技术分享

技术科普|首个 GraphRAG-Bench 如何评估九大 GraphRAG 性能?

导读:传统 RAG 遇瓶颈,复杂推理怎么办? GraphRAG 正成为知识管理新利器。 但关键问题来了:GraphRAG 真的超越了 RAG 吗?GraphRAG 哪家强?GraphRAG 性能评估标准有哪些?面针对不同场景需求如何选择?香港理工大学等学者在 6 月 3 日发表论文,重磅推出首个大规模、领域特定基准 GraphRAG-Bench,为技术选型提供硬核依据。

🔍本文翻译略有删减,论文原文如下

https://arxiv.org/pdf/2506.02404

一、摘要

图检索增强生成(Graph Retrieval-Augmented Generation, GraphRAG)因其在结构化组织领域特定语料库并提升复杂推理能力的潜力,正日益受到认可。然而,当前 GraphRAG 模型的评估主要依赖传统的问答数据集。这些数据集在问题广度和评估指标上存在局限性,无法全面衡量 GraphRAG 模型所带来的推理能力提升。

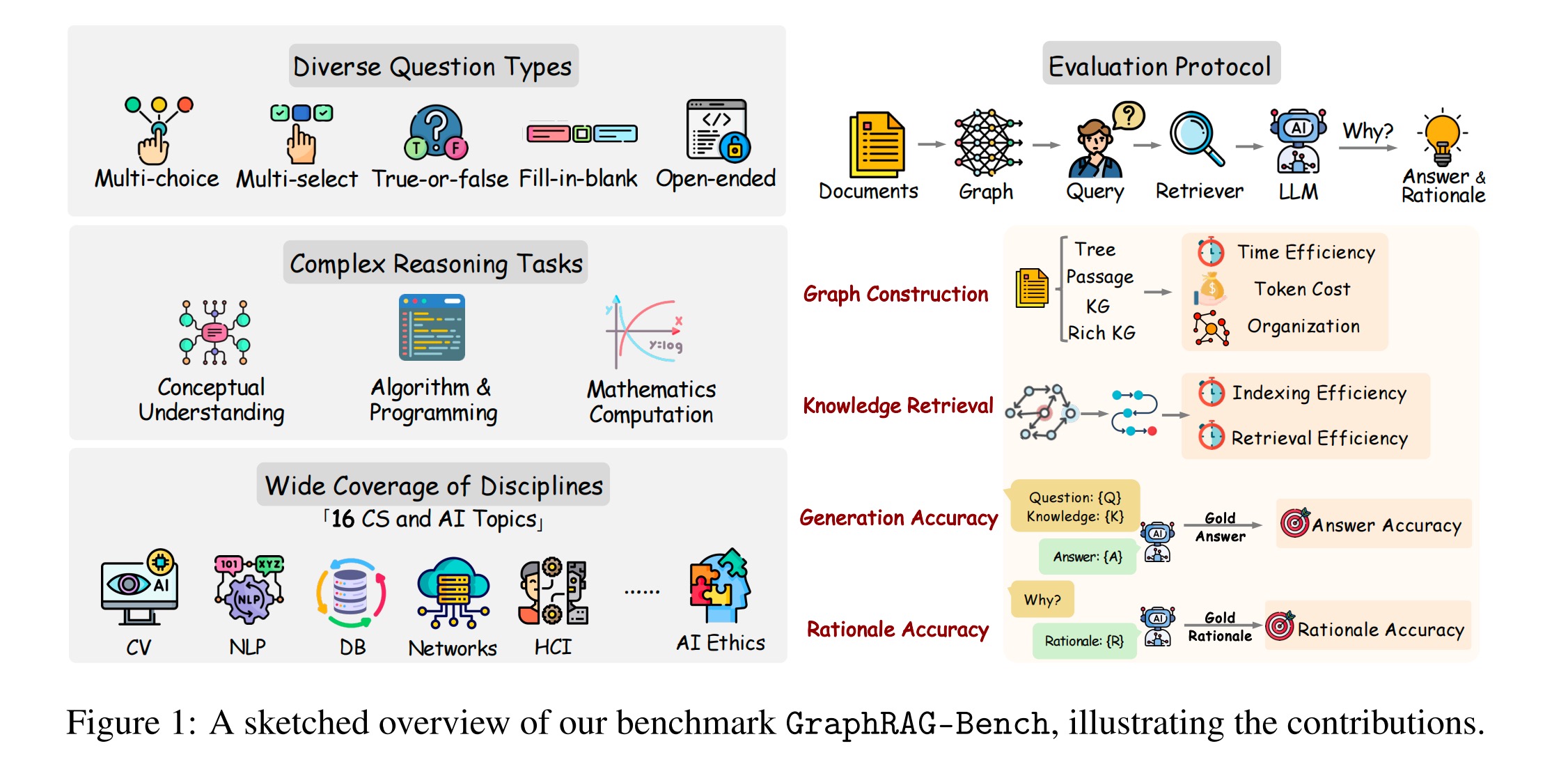

为弥补这一不足,我们提出了 GraphRAG-Bench,这是一个为严格评估 GraphRAG 模型而设计的大规模、领域特定基准。

我们的基准具备三大优势:

挑战性问题设计: 包含大学水平、领域特定的问题,要求进行多跳推理,确保仅靠简单内容检索不足以解决问题。例如,部分问题涉及数学推理或编程。

多样化任务覆盖: 数据集涵盖广泛的推理任务类型,包括单项选择(MC)、判断正误(TF)、多项选择(MS)、开放式问答(OE)和填空(FB)。问题来源覆盖 20 本核心教材中的 16 个学科。

全方位评估框架: GraphRAG-Bench 提供了覆盖整个 GraphRAG 流程的全面评估,包括图构建、知识检索和答案生成。除了最终答案的正确性,它还评估推理过程的逻辑连贯性。

通过将九种前沿 GraphRAG 方法应用于 GraphRAG-Bench,我们量化了基于图的结构化如何提升模型推理能力。我们的分析揭示了关于图架构、检索效能和推理能力的关键见解,为业界研究提供了可操作的指导。

GraphRAG-Bench 的所有相关资源均已收集在:

https://github.com/jeremycp3/GraphRAG-Bench

二、研究背景

检索增强生成(Retrieval-Augmented Generation, RAG)已成为将大型语言模型(Large Language Models, LLMs)植根于外部知识的关键解决方案,用以缓解幻觉问题及领域知识匮乏的问题。通过从语料库中检索相关文本片段,RAG 为 LLM 注入事实性知识,以生成更可靠的输出。

然而,传统的 RAG 系统在处理复杂推理场景时仍不尽如人意。RAG 中的扁平检索仅基于相似度匹配直接返回零碎的文本块,这限制了其对概念间复杂关系建模的能力,难以回答需要多跳推理、全局理解问题。例如:

“2008年雷曼兄弟破产事件对埃隆·马斯克的特斯拉公司有何影响?”

“贸易政策变革事件的主要思想是什么?”

为应对这些局限,图检索增强生成(GraphRAG)被广泛研究,旨在以图的形式捕捉概念间的结构化知识。其中节点代表概念,边代表概念间的关系。GraphRAG 的最新进展可归纳为三个主要方向。

分层图构建方法,通过树形结构和社区检测来组织知识。

神经图检索方法,采用图神经网络编码器并结合专门的目标函数进行多跳推理。

动态知识集成系统,开发了与 LLM 紧密耦合的自适应图构建和遍历机制。

通过将知识结构化为图,GraphRAG 不仅使 LLM 能够沿着显式关系路径进行遍历和推理,还能基于图结构推断隐含关系,从而支持更深层次的推理。

然而,尽管前景广阔,现有的 GraphRAG 方法基准未能充分反映其在图结构上进行推理的性能。这些基准主要利用传统的问答数据集,如 HotpotQA 、2WikiMultiHopQA 和 MuSiQue ,这些数据集仅包含复杂度有限、答案简短的显式事实性问题,例如“Dambar Shah 的孙子是谁?”。

这些数据集存在三个关键局限:

仅包含常识性问题,这些问题可能已被 LLM 的训练语料覆盖。

通常仅需基于显式连接的单跳或浅层多跳推理,不足以探明图结构知识的独特优势。

答案形式单一: 多数答案为简短形式(名称、日期)或选择题,难以反映基于图的推理能力。

因此,我们提出一个研究问题:

“GraphRAG 是否真正超越了传统 RAG,提升了模型的推理能力?”

三、研究方法与实验设计

(一)研究方法

1. 问题设计

为了在大学水平推理上评估 GraphRAG 框架,我们首先构建了一个权威教材语料库。从涵盖计算机科学 16 个不同子领域的 100 多份出版物出发,系统性地筛选出最具代表性的 20 本教材。我们定义了五种问题类型,每种针对 GraphRAG 推理能力的不同方面。最终选取出 1018 道高质量挑战性问题,覆盖了广泛的主题。

2. 语料库收集与处理

(1)预处理阶段区分 PDF 文本页与扫描页,分别采用直接提取和 OCR,并提取教材元数据(大纲、章节页码)。

(2)内容解析阶段:

使用 LayoutLMv3 进行多模态布局分析,分割页面为标题、段落等语义块

用 YOLO 模型检测并隔离数学公式区域避免 OCR 错误

对扫描页指定区域应用 OCR 获取文本

(3)后处理阶段通过 MinerU 工具按阅读顺序重组可能混乱的解析元素(文本、公式等)。

(4) 基于元数据构建四级层级结构(书名→章→节→知识单元),形成带结构标注的教材树。

3. 专家撰写推理依据

现有基准通常仅提供最终答案或显式图路径。相比之下,我们的数据集提供了专家撰写的推理依据,清晰阐述了解决每个问题所需的完整逻辑推进过程。

这些推理依据超越了简单的语料聚合,是结构化的叙述,能够:(i) 分离出前提概念,(ii) 描述这些概念间的关系,以及 (iii) 指明问题求解过程中应用的推理操作。

通过追踪逻辑推理和知识交互的每一步,我们可以评估 GraphRAG 模型是否真正生成了基于上下文的解释,还是仅仅利用了表面模式。

为实现细粒度、主题特定的评估,我们数据集中的每个问题都带有两个层级标签:一个宽泛的子领域(Level 1,例如“机器学习”)和一个更细粒度的概念(Level 2,例如“无监督学习”)。这些标注支撑了我们的后验分析。对于每个主题,我们不仅衡量模型答案的准确性,还衡量其生成的推理依据与标准依据的契合度。通过这种方式,我们将评估转化为一个多维过程,要求模型既要提供正确答案,也要生成忠实可信的推理模式。

(二)实验设计

1. 评估指标

图构建:

效率 (Efficiency): 构建完整图所需的时间。

成本 (Cost): 图构建过程中消耗的 token 数量。

组织度 (Organization): 构建图中非孤立节点所占的比例(衡量图的连通性)。

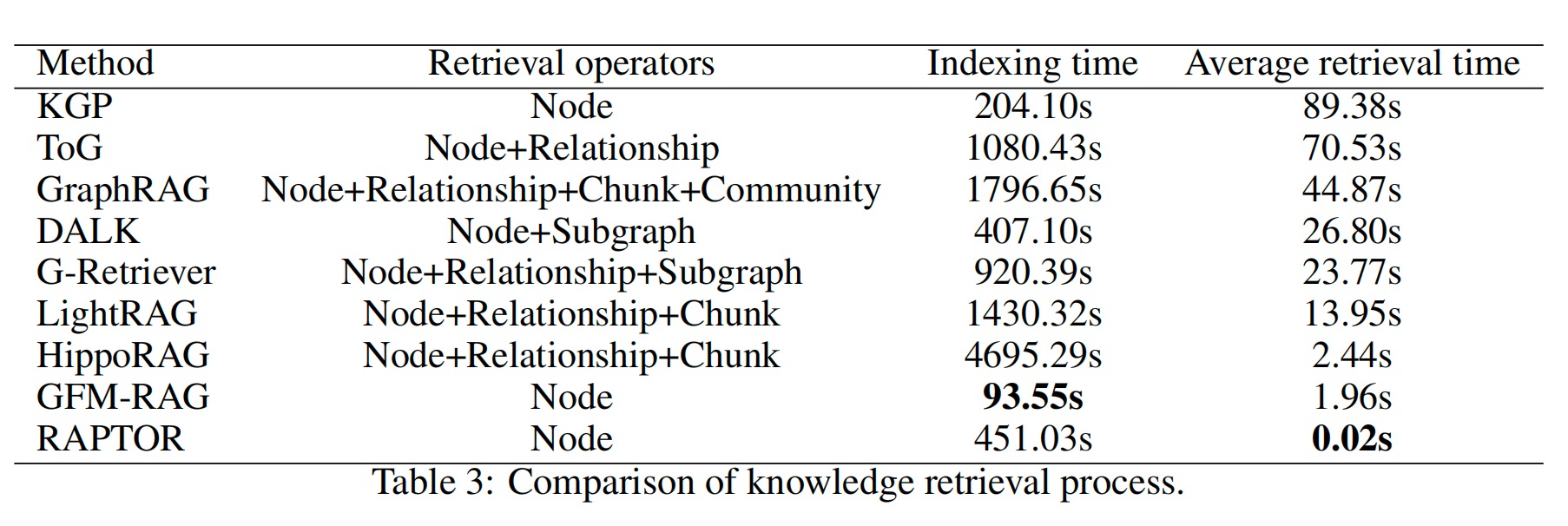

知识检索:

索引时间 (Indexing time): 构建用于检索的向量数据库所需的时间。

平均检索时间 (Average retrieval time): 每个查询进行知识检索的平均耗时。此外,我们总结每种方法使用的检索操作对象(Retrieval operators)以评估其检索机制的复杂度。

生成:

我们认为现有的精确匹配(exact match)指标并不合适,因为正确答案无需逐词对应。因此,本文引入了一个新指标:准确率 (Accuracy),定义如下:

OE 和 FB 问题: 将生成输出和标准答案通过我们设计的提示词(prompt)输入一个 LLM,该 LLM 基于语义对齐和正确性打分。

MC 和 TF 问题: 答案正确得 1 分,否则 0 分。

MS 问题: 完全正确得 1 分;部分正确得 0.5 分;错误得 0 分。

推理依据:

推理得分 (R, Reasoning Score): 我们设计了一个提示词,将 GraphRAG 方法生成的推理依据和标准依据输入一个 LLM,该 LLM 给出一个推理得分(R)以评估它们的语义对应和推理一致性。

答案相关推理得分 (AR, Answer-related Reasoning Score): 我们额外开发了 AR 指标,用于判断当模型准确回答问题时,其是否能提供正确的推理。此指标旨在区分模型是仅仅猜对了答案,还是确实通过合理的逻辑推理得出了正确答案,从而更全面地理解模型性能。

2. 实验设置

评估了九种前沿 GraphRAG 方法的性能,为确保所有方法公平比较,采用相同的 GPT-4o-mini 作为默认的大型语言模型。我们没有设置最大 token 长度来限制单个方法的性能。对于需要选择 top-k 的方法,我们统一设置 k=5。在文本分块方面,块大小统一设置为 1200 个token.

四、实验结果

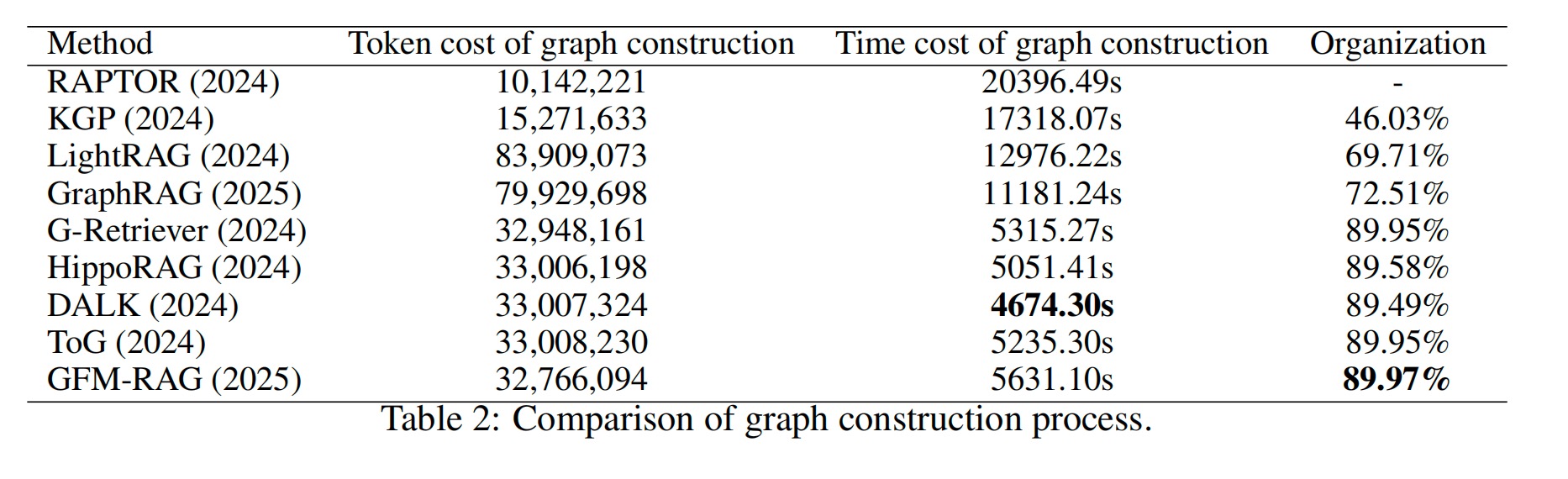

(一)图构建评估

1. Token 与时间成本

树结构的 Token 成本最低,因为它仅调用 LLM 生成摘要,但由于迭代聚类,耗时最长。

段落图的 Token 成本次优,仅调用 LLM 总结实体或关系,时间成本第二长,归因于耗时的实体链接过程。

知识图谱 Token 消耗适中,需要 LLM 进行实体提取和三元组生成,但因三元组获取后知识图谱构建快速,达到最短耗时(DALK 最快)。

丰富知识图谱 Token 消耗最多,因为它在标准知识图谱基础上通过LLM为实体和关系生成额外描述,导致时间成本增加。

2. 组织度

使用非孤立节点比例作为指标(树结构不适用此指标)。结果显示知识图谱表现最佳,其非孤立节点比例保持在约90%。丰富知识图谱表现次优;虽然引入了额外信息,但也不可避免地引入了更多噪声。段落图的非孤立节点比例最低,表明实体链接工具未能有效建立大多数实体对之间的边。

(二)知识检索评估

索引时间: GFM-RAG 索引时间最短;它不构建传统的向量数据库存储实体,而是在图构建阶段专门存储与问题对应的实体。在使用向量数据库的方法中,KGP、RAPTOR 和 DALK 因存储信息量少而成本较低;ToG、G-Retriever 和 LightRAG 成本适中,因为存储关系本身耗时;GraphRAG 因额外存储社区报告而进一步增加索引时间。HippoRAG 索引时间最长,归因于其额外构建实体<->关系和关系<->文本块映射。

平均检索时间: RAPTOR 速度最快,其树结构能快速定位信息。GFM-RAG 和 HippoRAG 紧随其后,分别利用 GNN 和 PageRank 算法进行检索。G-Retriever 采用带奖励收集斯坦纳森林算法(Prize Collecting Steiner Forest),LightRAG 依赖基于关系的检索,两者都引入了额外延迟。GraphRAG 需要利用社区信息检索,导致耗时较长。KGP、ToG 和 DALK 因检索时依赖调用 LLM 而产生显著时间成本。

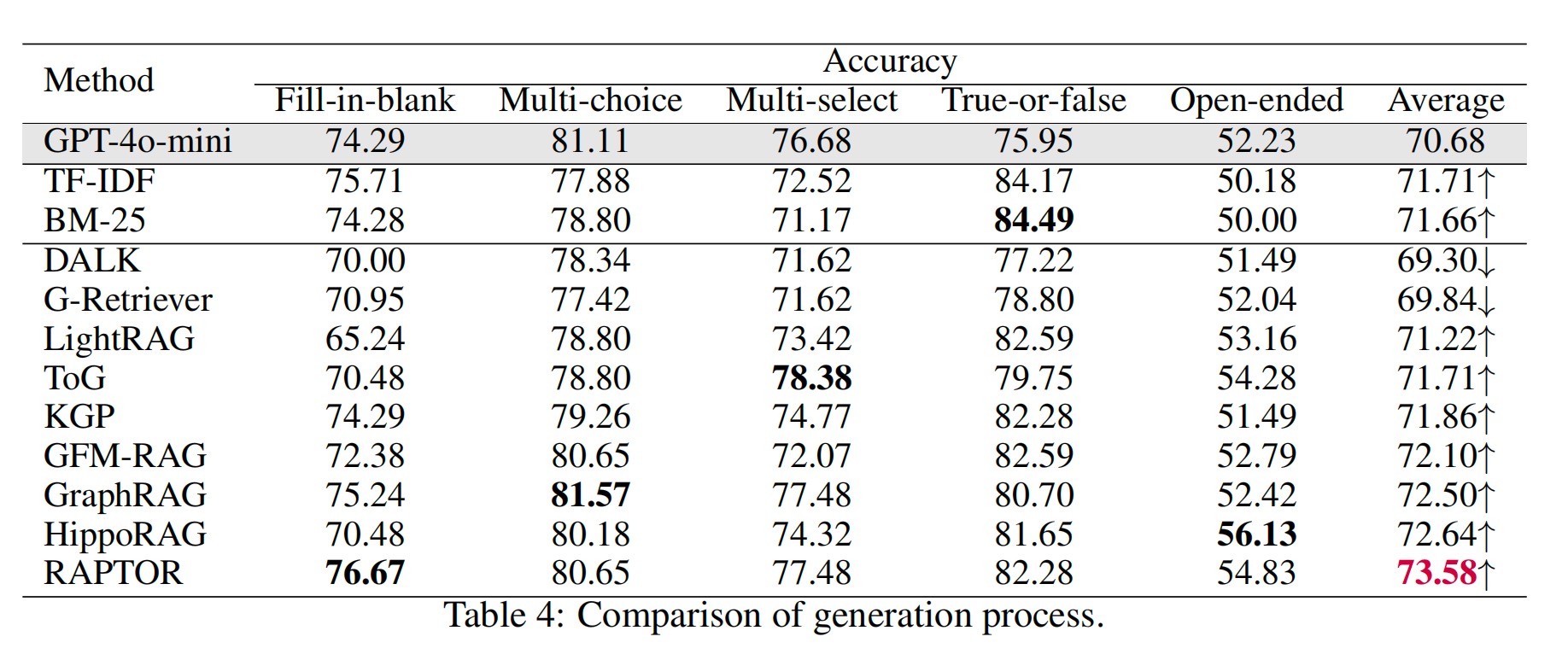

(三)生成准确率评估

鉴于 GPT-4o-mini 本身已具备较强的问答能力,并非所有 GraphRAG 方法都能有效提升其性能。

性能下降: DALK 和 G-Retriever 反而降低了 LLM 性能;它们过度依赖结构信息而牺牲了语义内容,在生成过程中引入了过多噪声,损害了 LLM 的判断准确性。

小幅提升: LightRAG、ToG 和 KGP 实现了小幅性能提升,表明其检索到的内容对生成任务提供了有限的帮助。

显著提升: 相比之下,GFM-RAG、GraphRAG 和 HippoRAG 通过有效整合图结构信息和文本块级语义显著提升了 LLM 性能:GFM-RAG 利用大规模预训练获得鲁棒的基础模型,GraphRAG 利用基于社区的信息优化检索,HippoRAG 通过 PageRank 算法提升检索效率。

最佳方法: 实验中表现最佳的方法是 RAPTOR,它通过迭代聚类构建树结构,这种设计与教材数据天然的分层组织结构高度契合,能够高效检索相关信息。

超越传统 RAG: 大多数 GraphRAG 方法优于 BM-25 和 TF-IDF 等传统 RAG 基线,突显了基于图的架构在提升生成准确率方面的效用。

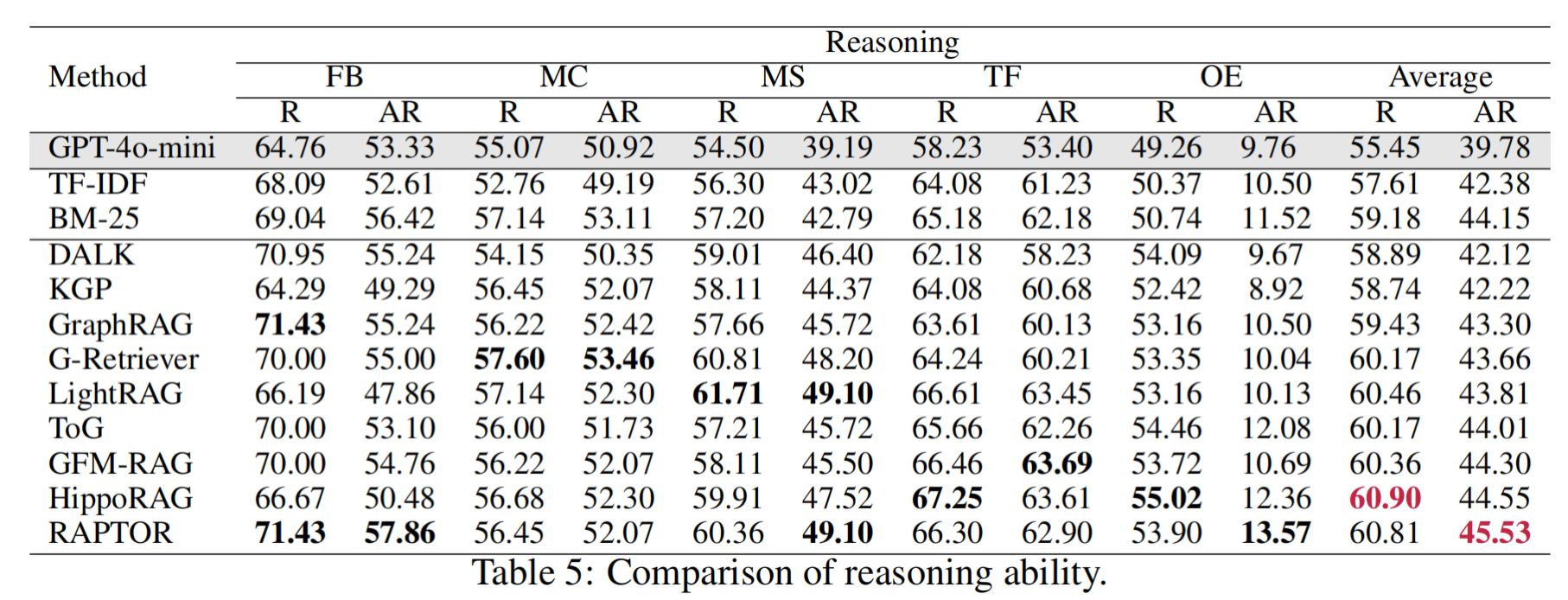

(四)推理能力评估

与生成任务的高准确率相比,GPT-4o-mini 在推理性能( R 和 AR 得分)上表现出显著下降。R 得分的下降表明 LLM 常常无法进行正确推理,而是在许多情况下通过猜测或模式匹配来选择答案。AR 得分的下降表明,即使 LLM 提供了正确答案,其推理过程也可能存在缺陷;或者它们可能生成了正确推理但选择了错误答案。

显著提升: 所有 GraphRAG 方法都显著增强了 LLM 的推理能力:通过不同的算法设计,这些方法不仅检索到与问题语义相关的语料,还识别出知识库中具有多跳依赖性的语料,为 LLM 的推理提供了证据支持。这使得 LLM 能够基于外部信息进行推理,而非仅依赖内部知识进行猜测。

算法性能分布: 在算法性能分布上,与生成任务类似:HippoRAG 和 RAPTOR 仍是表现最好的,这很直观,因为检索到有用信息本身就与实现正确推理相关。

超越传统 RAG: 大多数 GraphRAG 方法仍然优于传统 RAG 基线(TF-IDF, BM-25)。

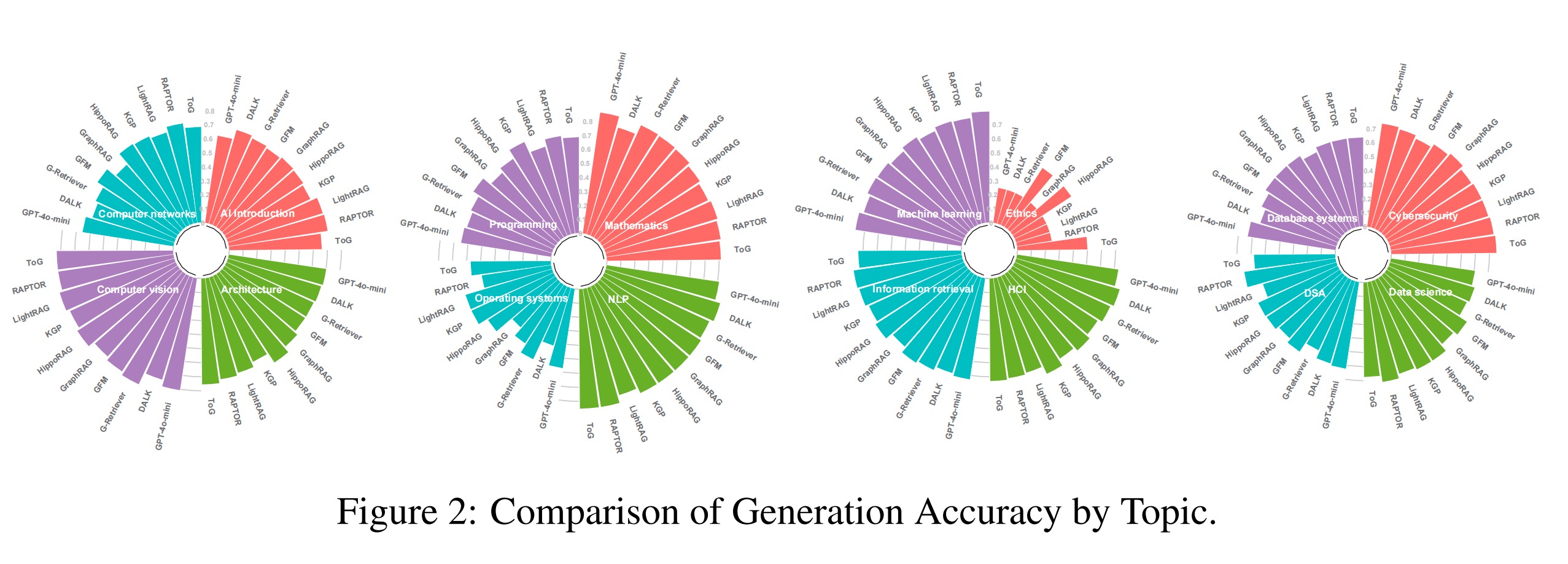

(五)主题特定生成准确率分析

鉴于我们的数据集跨越 16 个不同主题领域,我们对 GraphRAG 对 LLM 生成准确率的影响进行了细粒度分析。总体而言,GraphRAG 在大多数领域带来了一致的提升。然而,也发现了一些有趣的发现:

数学领域: 所有 GraphRAG 方法都降低了 LLM 在数学题上的生成准确率。这是因为数学问题关键依赖于严格的符号操作和精确的推理链;模型必须在内部“计算”每个演绎步骤,而非依赖外部文本的关键词匹配。通过 GraphRAG 检索到的大多数文档是解释性或概念性的,其符号表示、公式布局和上下文结构常与问题要求不符,导致信息提取和转换过程中产生歧义或关键步骤丢失。

伦理领域: GraphRAG 和 LLM 本身在伦理题上的表现都平平。我们认为伦理问题从根本上涉及主观价值判断,其含义取决于道德权衡和社会规范的动态语境。LLM 通过统计学习捕捉的符号表示难以准确建模模糊的伦理概念,在推理上存在固有局限。

稳健性: 优秀的 GraphRAG 方法在大多数主题上显著提升了 LLM 的生成准确率,展现出稳健的性能,验证了其跨领域有效性。

五、Observation

🙋GraphRAG 能否提升所有问题类型的性能?

单项选择问题准确率下降: LLM 通过在大型语料库上的广泛训练内化了海量知识,使其在选择题任务中常能正确选择答案。然而,GraphRAG 基于检索的增强可能引入冗余或松散相关的信息,这些信息与问题语境并非精确匹配。此类检索噪声会干扰模型的决策能力,最终降低其在单项选择问题上的准确率。

判断正误问题性能提升: TF 问题需要对事实或逻辑陈述进行二元判断。LLM 可能对某些事实存在盲点或不完整的知识,导致错误答案。通过检索相关的事实证据,GraphRAG 帮助模型在回答前验证陈述。这些补充信息提高了模型在判断正误问题上的准确率。

开放式问题性能提升: 开放式问题允许广泛、详细的回答,这对于仅依赖内部知识的 LLM 来说可能具有挑战性。GraphRAG 通过提供来自外部语料库的额外上下文和事实来缓解这一挑战。检索到的信息丰富了模型的回答,提升了主题细节和表达能力,并通过将答案基于明确证据来减少幻觉。

填空和多项选择问题的不同效果: 填空问题需要精确的上下文理解以正确预测缺失词。GraphRAG 检索到的语料通常无法匹配确切的语境,引入噪声从而降低模型在填空问题上的表现。多项选择题需要从一组选项中选择多个正确答案,涉及对选项复杂组合的推理;如果 GraphRAG 的检索遗漏了相关答案选项或包含了无关细节,则可能混淆模型。因此,这些问题类型对检索精度要求很高;除非 GraphRAG 的检索非常精确,否则其收益可能有限。

🙋GraphRAG 能否有效增强 LLM 的推理能力?

实验表明,GraphRAG 能有效增强 LLM 在各种问题类型上的推理能力,提高了在生成答案的同时生成正确推理依据的概率。

这归功于其高效的检索机制,不仅能为问题识别高度相关的语料,还能为 LLM 的推理过程提供有力的证据支持。特别是,现有基准缺乏对 GraphRAG 推理能力的系统性评估,而这在实际应用中至关重要。例如,在本文针对的大学级教育场景中,寻求专业知识的用户不仅期望正确答案,还期望清晰的推理依据以促进理解和知识获取。同样,在医疗场景中,患者需要清晰的用药依据和治疗建议,以确保决策的透明度。因此,有效的 GraphRAG 方法不仅应追求答案生成的高准确率,还应追求强大的推理和可解释性。

六、结论

本文提出了 GraphRAG-Bench,这是首个专为 GraphRAG 设计的领域特定基准。它包含一个跨越 16 个学科的数据集,通过多跳推理、复杂算法/编程任务、数学计算和多样化问题类型挑战现有方法,覆盖图构建、知识检索、生成和推理的全方位、多维评估,量化了结构化知识增强对 LLM 推理能力的提升。在九种前沿 GraphRAG 方法上进行的广泛实验,揭示了图集成在提升推理和生成性能方面的重要作用。